Windows 部署 DeepSeek 详细教程

一、准备工作

- 系统要求: 建议Windows 10 22H2 或更高版本,家庭版或专业版

- 上网环境: 建议科学上网,国内访问部分网站会很慢

- 设备要求: 内存8G以上、关闭防火墙

二、安装Ollama

- 官网链接: https://ollama.com/download

- github链接: https://github.com/ollama/ollama

1、进入官网下载Windows版本(未科学上网,下载可能会很慢,请耐心等待)

2、双击安装

3、安装完成后,win+R 输入cmd,在窗口中输入 ollama -v ,输出版本号则代表安装成功

软件默认安装位置:C:\Users\用户名\AppData\Local\Programs\Ollama

模型默认存放位置:C:\Users\用户名\.ollama\models

日志默认存放位置:C:\Users\用户名\AppData\Local\Ollama

三、Ollama环境变量配置(可选)

| 参数 | 标识与配置 |

|---|---|

| OLLAMA_MODELS | 表示模型文件存放目录,默认存放在C盘,可以更改为其他盘(如 D:\ollama\models) |

| OLLAMA_HOST | 表示 ollama 服务监听的网络地址,默认为127.0.0.1:11434,想要允许其他电脑访问ollama 服务的话,改成:0.0.0.0:11434,后面端口可以修改 |

| OLLAMA_KEEP_ALIVE | 表示大模型加载到内存的存活时间,默认5分钟;0代表请求后立即释放、1m代表在内存中保持1分钟、1h代表在内存中保持1小时;建议设置成 24h ,即模型在内存中保持 24 小时,提高访问速度 |

| OLLAMA_NUM_PARALLEL | 表示模型同时执行的最大并行请求数量,默认无限制,设置为1后,同一时间只能一人访问,其他人需要等待 |

1、打开 我的电脑-右键属性-高级系统设置-环境变量

2、用户变量点击新增-确定,保存后,需要重启电脑

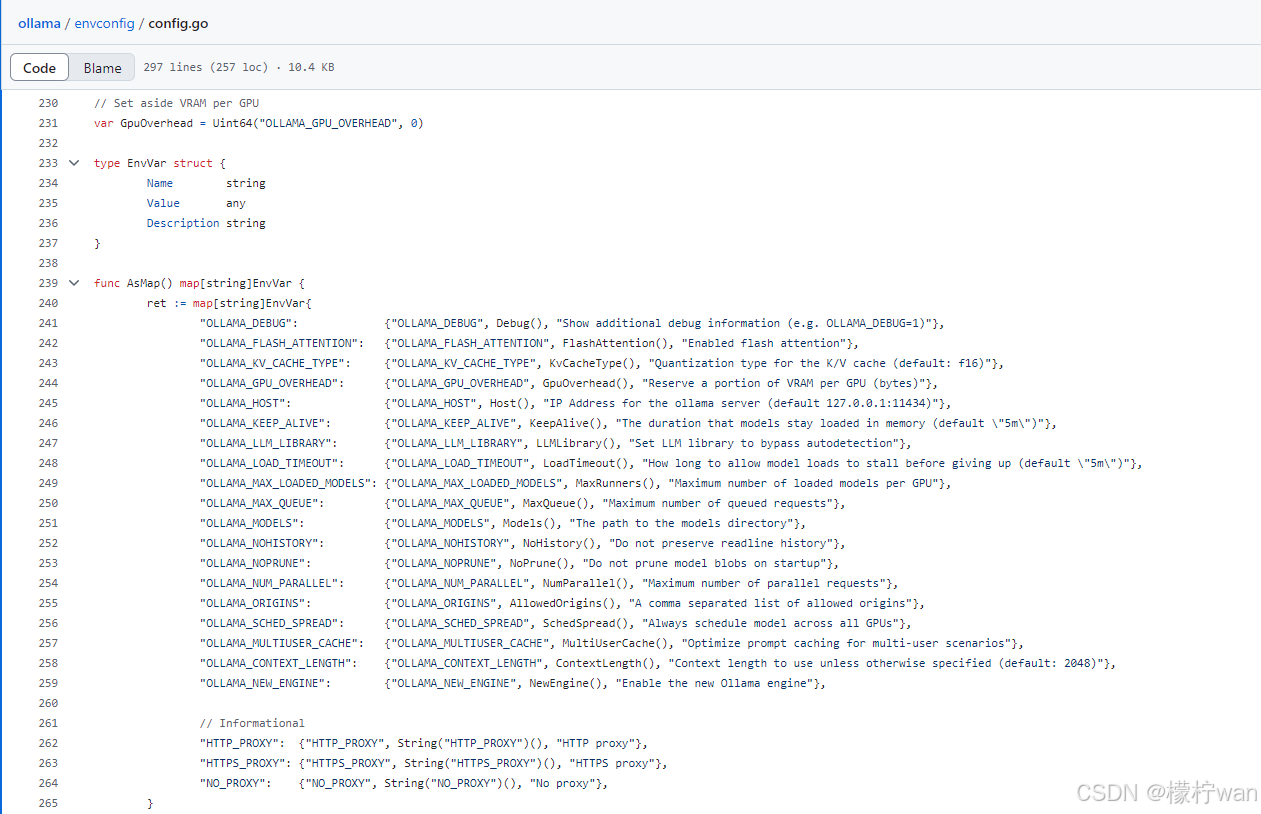

其它环境变量配置参数: https://github.com/ollama/ollama/blob/main/envconfig/config.go

四、运行DeepSeek-R1模型

模型链接: https://ollama.com/library/deepseek-r1:1.5b

提供以下模型参数,根据设备实际情况下载对应模型参数,当前演示下载的1.5b

1、win+R 输入cmd,先下载模型,再运行模型(也可以直接按照官网方法)

2、停止模型方法

以上方法是通过命令行进行对话,如需要web端对话方式,继续往下部署(Page Assist 和 Open WebUI二选一即可)

五、配置web UI 访问(可选)

1、Page Assist使用方法

- github链接: https://github.com/n4ze3m/page-assist

Ⅰ、Page Assist是浏览器插件,支持Chrome、Firefox、Edge,当前演示会使用Edge,在https://github.com/n4ze3m/page-assist/releases中下载Edge压缩包,并解压到桌面

Ⅱ、运行Edge,点击右上角三个点-扩展-管理扩展,启用开发者模式,加载解压后的文件,然后运行

Ⅲ、配置Ollama的服务地址(设置中可以选择中文)

默认首次运行,会要求你设置Ollama地址,如未出现上述图片,请按照下方设置地址

Ⅳ、选择模型,配置完成后就可以使用啦

注:Page Assist如果安装在局域网其他设备上,连接Ollama服务时,需要设置OLLAMA_HOST环境变量才能连接上

2、Open WebUI 使用方法

- Open WebUI开源地址:https://github.com/open-webui/open-webui

- Open WebUI官方文档: https://docs.openwebui.com/

UV方式安装

Ⅰ、 安装 uv 工具

- uv开源地址:https://github.com/astral-sh/uv

Windows打开powershell运行(安装时间比较久,请耐心等待)

powershell -ExecutionPolicy ByPass -c "irm https://astral.sh/uv/install.ps1 | iex"

Ⅱ、运行 Open WebUI(首次需要下载很多文件)

运行方法二选一,第一个默认端口8080,第二个指定端口5000

默认端口:8080

$env:DATA_DIR="C:\open-webui\data"; uvx --python 3.11 open-webui@latest serve指定端口: 5000

$env:DATA_DIR="C:\open-webui\data"; uvx --python 3.11 open-webui@latest serve --port 5000

出现以下内容代表运行成功,通过浏览器访问(设备开机后不会自动运行,需要手动运行,启动过程需要几分钟)

或如下

以上命令如执行失败,请重新尝试…

Python方式安装

Ⅰ、下载python并安装(必须使用Python3.11.x版本,以避免出现兼容性问题)

- Python3下载官网(往下找稳定版3.11的):https://www.python.org/downloads/windows/

Ⅱ、创建虚拟环境(会在当前路径下创建openwebui文件夹)

python -m venv openwebui

Ⅲ、激活虚拟环境

openwebui\Scripts\activate

Ⅳ、安装 Open WebUI

pip install open-webui

Ⅴ、启用服务

默认端口:8080

open-webui serve指定端口:5000

open-webui serve --port 5000

后续启动服务只需要执行以下命令,激活虚拟环境,必须在你之前创建虚拟环境路径下执行(设备开机后不会自动运行,需要手动运行,启动过程需要几分钟)

openwebui\Scripts\activateopen-webui serve

其他安装方法可参考Open WebUI官方文档: https://docs.openwebui.com/getting-started/quick-start/

Ⅰ、浏览器输入设备IP地址和端口,并按照要求设置管理员账户

- 本地浏览器访问:127.0.0.1:端口号

- 局域网设备访问:设备IP:端口号

Ⅱ、点击头像-管理员面板-设置-外部连接-设置Ollama IP和端口,其他禁用,设置完成,就可以正常访问啦

注:需要部署Web UI在无外网的局域网中使用,请选择 Page Assist 或 Python方式安装的Open WebUI