大模型时代的基础架构 读书笔记

第一章 AI与大模型时代对基础架构的需求

- 大部分机器学习算法的核心操作都是基于乘加累积运算的向量卷积运算。所以“加速” AI 运算指的就是如何通过 GPU 中的海量计算单元实现并行化的向量卷积运算。

- 能实现 AI 运算的硬件:

第二章 软件程序与专用硬件的结合

- GPU 中能多线程并发执行运算的硬件单元分类:

- GPU 执行运算的简要步骤:

- GPU 中 CUDA Core 执行运算的简要步骤:

- 出现机器学习框架的原因:

- 提供综合、统一、便捷的框架给开发者使用。避免自己单独造各种机器学习算法的轮子。

- 单纯面向底层硬件编程,不但学习曲线陡峭、上手难度高,而且产出效率低。不利于 AI 产品的快速落地。

- 机器学习框架支持的训练方式:

第三章 GPU 硬件架构剖析

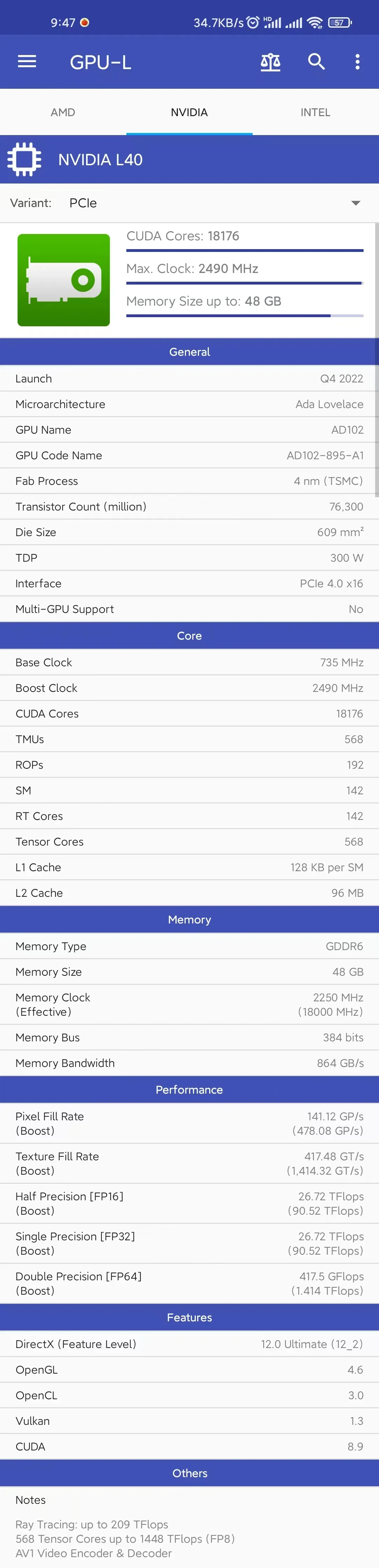

💡 以 nVIDIA 最新发布的 Ada Lovelace 架构的纯计算型 GPGPU - L40 为例介绍 GPU 的硬件架构。

- Tesla L40 纯计算卡的硬件参数及性能信息:

- Ada Lovelace 架构: