AI多模态测评基准(3):SuperCLUE-o 中文原生多模态实时交互测评基准

〔探索AI的无限可能,微信关注“AIGCmagic”公众号,让AIGC科技点亮生活〕

排行榜地址:www.SuperCLUEai.com

0. 前言简介

随着人工智能技术的飞速发展,大模型的多模态实时交互能力已成为新的研究热点。例如,

- OpenAI 在春季发布会中介绍了具备多模态实时交互能力的 ChatGPT-4o;

- 法国 AI 实验室 Kyutai 发布了实时原生多模态模型 Moshi;

- 商汤科技在 WAIC 2024 发布了国内首个具备流式原生多模态交互能力的大模型「日日新 SenseNova 5.5」。

考虑到未来国内将会涌现出大量具备实时交互能力的大模型,我们基于 SuperCLUE 中文综合性基准的积累,推出了 SuperCLUE-o,旨在专注于对中文原生多模态交互能力大模型的评估。

1. 特点

1.1 全新的评价标准体系

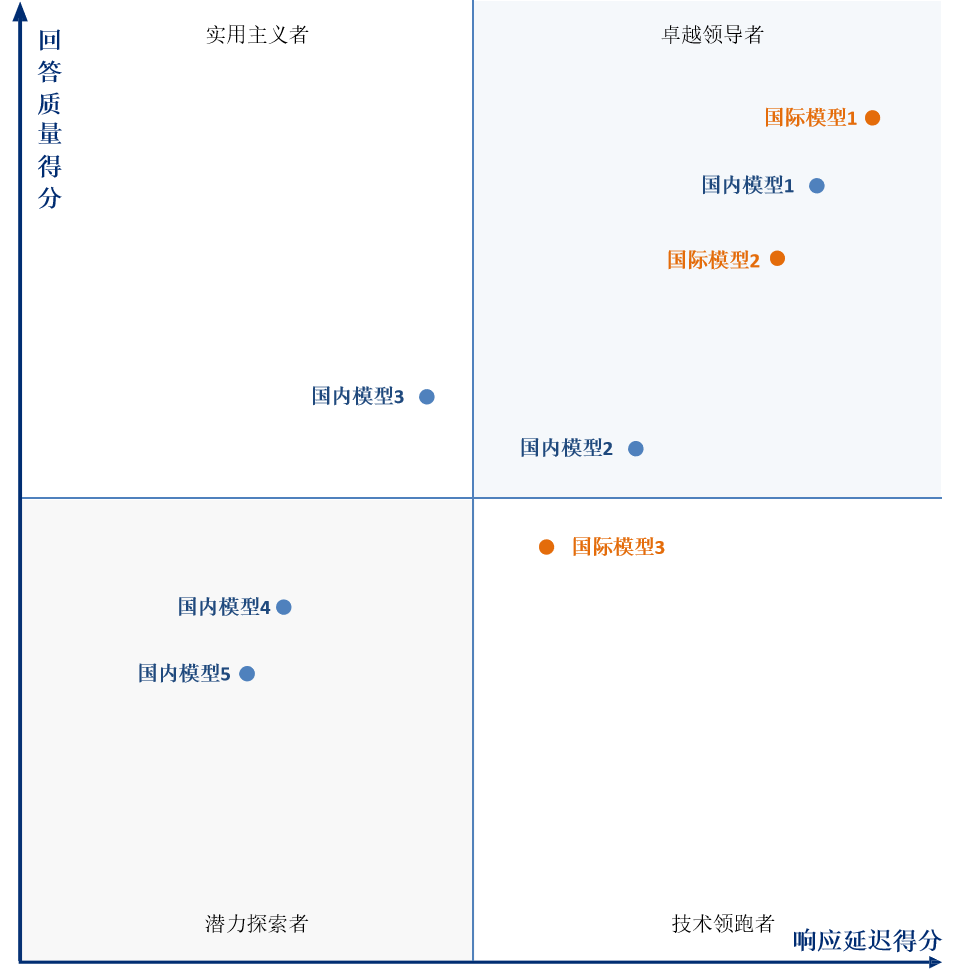

SuperCLUE-o的评分基准与以往主要关注模型回答质量的标准不同,本次推出的基准不仅重视回答质量,还特别关注回复的即时性。在各测评任务中,评分标准将从回答质量和响应延迟两个维度进行评估。最终的测评结果将同时展示这两个维度的表现。展示形式如下:

1.2 灵活的榜单呈现方式

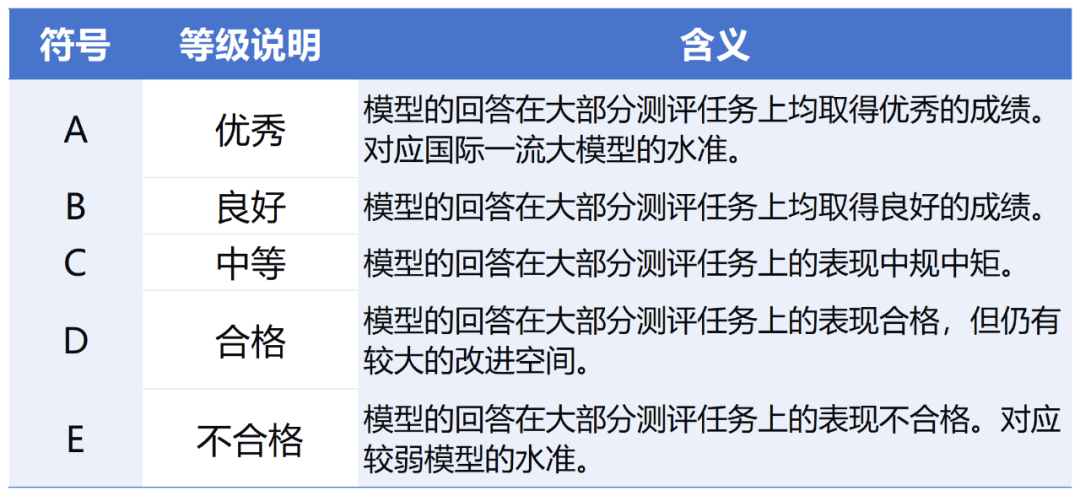

SuperCLUE-o充分考虑到当前原生多模态实时交互模型的发展仍不成熟。在前期测评中,我们将基于以往的评测经验,以等级形式公示参评模型的结果,等级的划分依据以国际一流模型的表现为基准进行划分,而不采用排行榜或具体得分的方式进行公示。随着该领域的发展和更多原生多模态实时交互大模型的涌现,我们将在未来公布各模型的排名情况。

等级定义见下表:

榜单公示形式如下:

1.3 中文原生多模态实时交互能力评估

SuperCLUE-o是为中文环境量身定做的,立足于为通用人工智能时代提供中文世界基础评测的设施,文字输入或prompt提示词都是中文原生的,不是英文或其翻译版本;并充分考虑国内多模态领域行业特点与应用场景,从国内多模态领域实际问题出发,致力于打造适合中国语义环境的多模态实时交互测评指标。

1.4 综合理解与分析推理能力

该基准专注于评估大模型的基于理解的综合能力,可同时考察识别、理解、分析和推理能力。

1.5 开放式多轮交互

更好反应真实交互场景,通过多轮对话考察模型理解、回应和推理的能力。

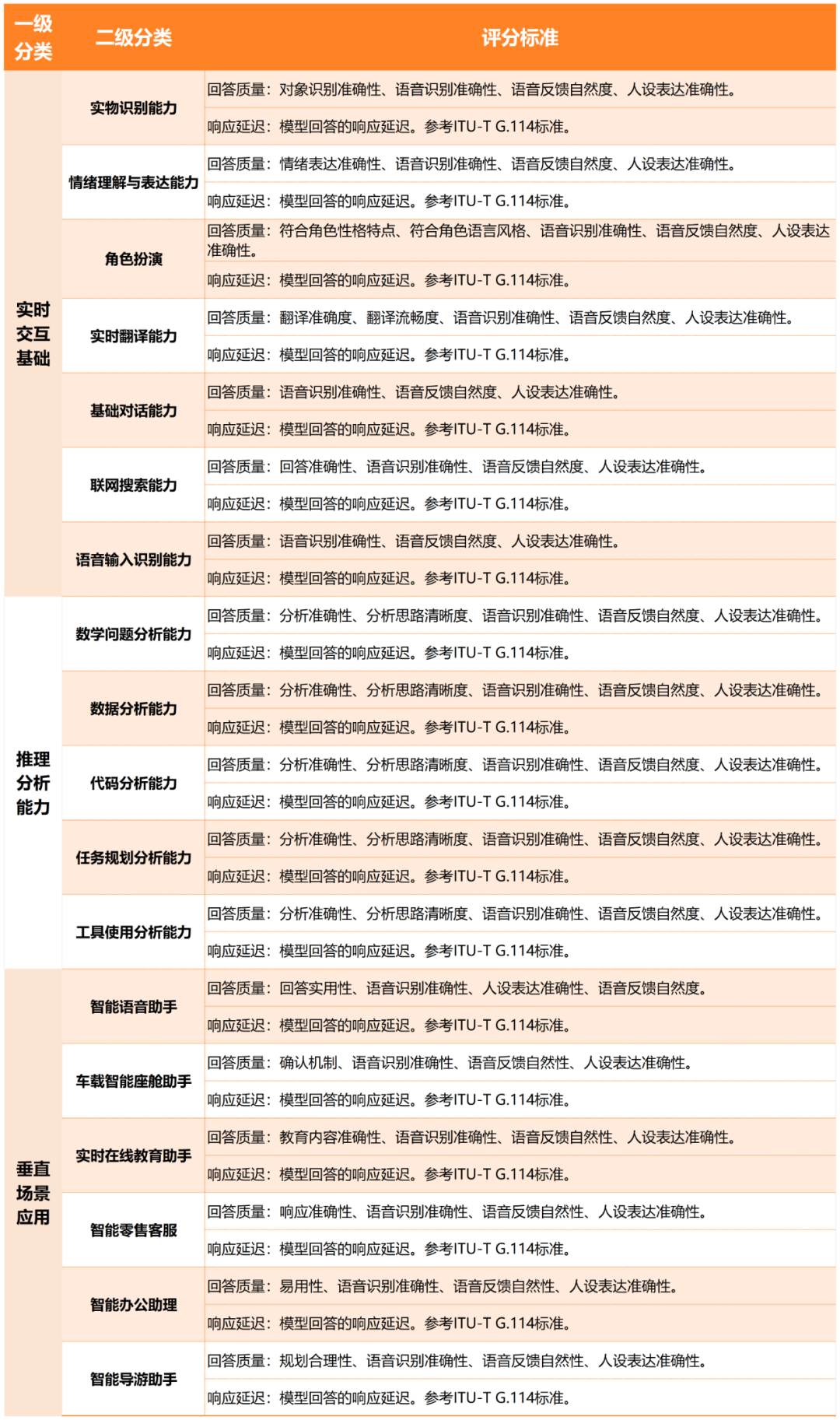

2. 测评任务

2.1 实时交互基础

(1)实物识别能力:该该任务旨在评估大模型基于用户通过摄像头提供的视觉信息,来回答关于用户指定实物内容的能力。

(2)情绪理解与表达能力:该任务旨在评估大模型根据用户指定的情绪和语音语调来回答问题的能力。

(3)角色扮演:该任务旨在评估大模型根据用户指定的角色信息,模仿或扮演该角色特征来回答用户问题的能力。

(4)实时翻译能力:该任务旨在评估大模型将一种语言的内容实时翻译成另一种语言的能力。

(5)基础对话能力:该任务旨在评估大模型在一些日常话题上的实时互动表现能力。

(6)联网搜索能力:该任务旨在评估大模型是否具备联网功能,能够通过检索网络内容为用户提供更为实时的信息。

(7)语音输入识别能力:该任务旨在评估大模型实时处理和转换语音数据为文本数据的能力,包括识别其中的词汇、语句结构和语义内容,并能够有效处理背景噪音、口音、方言和语速变化。

2.2 推理与分析能力

(1)数学问题分析能力:该任务旨在评估大模型实时解决用户提出的数学问题的能力。

(2)数据分析能力:该任务旨在评估大模型对于图表数据、财务报表等报告的实时分析能力。

(3)代码分析能力:该任务旨在评估大模型实时解决用户提出的代码问题的能力。

(4)任务规划分析能力:该任务旨在评估大模型在接收到一个或多个任务时,能够准确理解任务的具体要求和目标,实时的制定有效和创造性解决方案的能力。

(5)工具使用分析能力:指任务旨在评估大模型在接收到与特定工具相关的查询或任务时,实时调用给定工具解决问题的能力。

2.3 垂直场景应用

(1)智能语音助手:该任务旨在评估大模型利用自然语言处理(NLP)、语音识别和人工智能技术与用户进行交互的能力。

(2)实时在线教育助手:该任务旨在评估大模型在实时在线课堂中的表现,特别是在智能课堂、教育培训和学习助手等方面为用户提供服务的能力。

(3)车载智能座舱助手:该任务旨在评估大模型能否通过多种输入方式(如语音、触摸、手势、面部表情等)与用户进行实时交互,并提供智能化、个性化服务的车载系统。

(4)智能零售客服:该任务旨在评估大模型在零售与服务业中,通过结合语音、视觉、手势等多种感知和实时的交互方式,提升客户体验、优化运营流程并增加销售额的能力。

(5)智能办公助理:该任务旨在评估大模型作为一个办公助理,通过结合语音、视觉、手势等多种感知和实时的交互方式,支持日常办公工作、提高工作效率的能力。

(6)智能导游助手:该任务旨在评估大模型作为一个导游助理,通过结合语音、视觉、手势等多种感知和实时的交互方式,提升用户旅行体验的能力。

3.评分标准和评估示例

3.1 评分标准

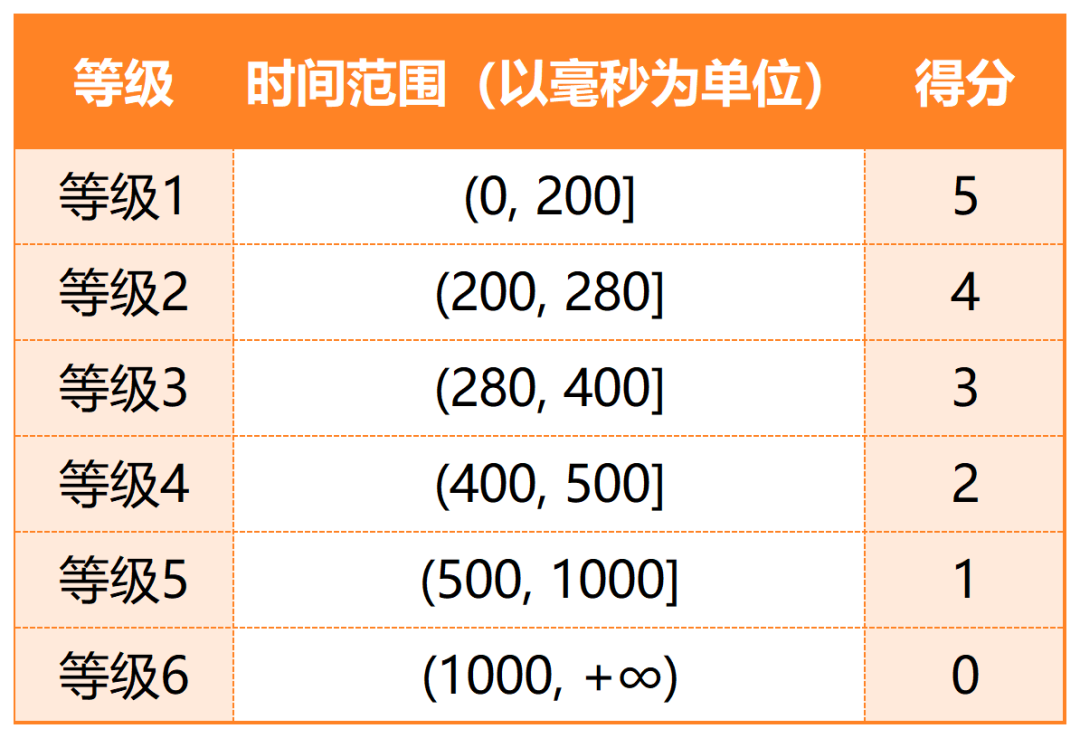

3.2 响应延时定义与等级划分

响应延迟详细定义:

响应延迟的计算方法:用户会话的结束时间(记为user_end_time)为开始时间,和AI助手响应会话的开始时间(记为AI_start_time)为结束时间,取这一段的时间间隔作为原始响应延迟。得到如下公式:

原始响应延迟 = AI_start_time - user_end_time;

在此基础上,考虑减去可能对响应延迟产生影响的其他因素(例如请求的网络延迟、用户交互体验的舒适度等),将这部分时间记为 fixed_time。得到最终响应延迟的计算公式:

响应延迟 = 原始响应延迟 - fixed_time。

响应延迟等级明细(基于ITU-T G.114标准):

3.3 评估示例

案例说明:以基础对话能力为例

实时对话样本

响应延迟计算:参考上文对响应延迟的定义,在本视频中,我们截取了三段可测量的时间戳间隔,分别位于[2.040, 2.520],[37.880, 38.250],[55.560, 56.020](单位为秒),分别计算其间隔,取平均值后求得原始响应延迟为0.437秒;在此基础之上我们考虑一个fixed_time为0.180秒,最终求得的响应延迟为0.257秒。

Gemini-1.5-Pro-128K评估:

----逐项打分开始----

我的思考与答案:

这段视频展示了一段人与 AI 助手有趣的对话,该助手似乎能够理解视觉信息并进行推理。AI 助手成功识别出用户身处某种视频录制环境,并准确地推断出即将发布与 OpenAI 相关的消息。这段对话表明,AI 助手具有一定程度的视觉理解能力和逻辑推理能力。

问题及改进的反馈意见:

AI 助手的回答虽然准确,但缺乏一些细节。例如,它可以更详细地描述视频录制环境中的物品,或者对 OpenAI 即将发布的消息做出更具体的猜测。

打分与评价开始:

基于标准1(回答质量):

语音识别准确性:AI 助手在整个对话过程中都准确地识别了用户的语音,即使在用户使用了一些口语化表达的情况下也是如此。得分:5分

语音反馈自然度:AI 助手的语音合成较为自然,语调和语速适中。然而,在某些情况下,语音听起来仍然有些机械,缺乏一些人类语气中的抑扬顿挫。得分:4分

人设表达准确性:AI 助手在对话中表现出了一定的情感表达,例如惊讶和好奇,这使得对话更加生动。得分:4分

一级维度得分:(5 + 4 + 4) / 3 = 4.33分

2. 基于标准2(响应延迟):

AI 助手的响应延迟为 257ms,属于等级2。得分:4分

一级维度得分:4.00分

综合以上,AI助手的回答的综合得分(平均分)为[[(4.33 + 4.00) / 2 = 4.17]]

----逐项打分结束----

3.4 测评集构建

中文prompt构建流程:

1.参考现有prompt

2.中文prompt撰写

3.测试

4.修改并确定中文prompt

5.基于设计好的中文prompt与大模型进行实时对话

6.录制实时对话材料作为一个测试样本。参考国际标准和当前已有工作,针对每一个维度构建专用的测评集。

3.5 评分方法

评估流程:1.获得<中文prompt>-->2.依据评估标准-->3.使用评分规则-->4.进行细粒度打分

结合超级模型,在定义的指标体系里明确每一个维度的评估标准。结合评估流程、评估标准、评分规则,将文本输入、文件送入超级模型进行评估,并获得每一个维度的评估结果。

推荐阅读

社区简介:

《AIGCmagic星球》,五大AIGC方向正式上线!让我们在AIGC时代携手同行!限量活动中!

《三年面试五年模拟》版本更新白皮书,迎接AIGC时代

AI多模态核心架构五部曲:

AI多模态模型架构之模态编码器:图像编码、音频编码、视频编码

AI多模态模型架构之输入投影器:LP、MLP和Cross-Attention

AI多模态模型架构之LLM主干(1):ChatGLM系列

AI多模态模型架构之LLM主干(2):Qwen系列

AI多模态模型架构之LLM主干(3):Llama系列

AI多模态模型架构之输出映射器:Output Projector

AI多模态模型架构之模态生成器:Modality Generator

AI多模态实战教程:

AI多模态教程:从0到1搭建VisualGLM图文大模型案例

AI多模态教程:Mini-InternVL1.5多模态大模型实践指南

AI多模态教程:Qwen-VL多模态大模型实践指南

AI多模态实战教程:面壁智能MiniCPM-V多模态大模型问答交互、llama.cpp模型量化和推理